Články s více tématy

Game Story: Na tenhle seriál jsem čekal třicet let

Zvonečkem to začalo, zvonečkem to končí, řekl by někdo. Po třiceti letech očekávání a zklamání přichází na Českou televizi…

Internetová tržiště musí zemřít

Dropshipment neboli prodej přes internetová tržiště nám předkládali jako téměř revoluční formu e-komerce. Dnes se ale…

Historie Amigy: Když nevíte kudy kam aneb čas slepých uliček

Minule jsme si povídali o tom, jak se Commodore ocitl na absolutním vrcholu. Firma prodávala miliony počítačů, od laciného…

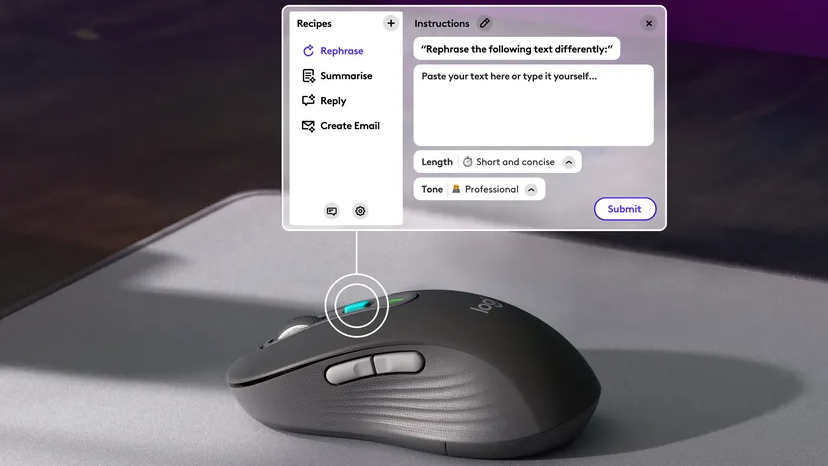

AI nám možná nevezme práci. Schválně si tipněte, proč

Jedno z pravidel technologického vývoje je to, že každá technologie, kterou jde i jen potenciálně zneužít, bude nakonec…

(AI)pokalypsa: Než nás AI zničí, aspoň bude sranda!

Zatímco do sebe buší technooptimisté a technoskeptici, musím konstatovat, že technologická apokalypsa, která na nás přichází…

Temu, fejky a další neodolatelné nabídky a slevy

Reklamy na Temu vtrhly na naše sociální sítě – a s nimi gamifikace nákupů, absurdní slevy a fejky všelijakého typu. Na to,…

Éra podivností: AppleVisionProHoles, Chomsky proti AI a další bizáry

„Simpsons to zase předpovídali“, vykřikují lidé a ukazují klip z The Simpsons, ve kterých ze sebe obyvatelé Spriengfieldu…

Bezcílné vedení Google v podstatě uctívá AI. Čas finančních výsledků #TYDEN 5. února

Boj s dezinformacemi na bodu mrazu. Pokles zpravodajského průmyslu. Recenze Apple Vision Pro. Apple rozpoutává válku s EU.…

PC stále není mrtvé: Tak kdy konečně přijde ten mobilní převrat?

Dlouhou dobu se mluví o tom, že mobily převálcují počítače. „A kdy se to jako má stát?“ smějí se mnozí. No – ono se to,…

Apple zkouší, co vydrží EU, vývojáři i uživatele. HP ostatně také #TYDEN 29. ledna

eDoklady shodily Identitu občana. Pirátství na vzestupu. Palword jede, možná i k soudům. Lednové propouštění je rekordní.

Na platformách Meta je denně sexuálně obtěžováno 100 000 dětí. Za nezájmu vedení #TYDEN 22. ledna

Každého uživatele Facebooku sledují tisíce firem. VMware zlikvidovalo 56 produktů. Vyhledávání Google se zhoršilo.

Bitcoin nemá žádnou hodnotu. Závislost médií na sociálních sítích končí #TYDEN 15. ledna

Hacknutý účet SEC na Twitteru. Obavy z Muska užívajícího drogy. Co Google v roce 2023 zabil. Platformer opouští Substack.…

Historie Amigy: Cesta k legendám Commodore Amiga 500 a Amiga 2000

Minule jsme si vyprávěli, jak Commodore sice s velkou slávou zakoupil firmu Amiga a choval se velkopansky jako bohatý ženich…

EU: cookie bannery jsou obtěžující. 23andMe obviňuje oběti hacku z hlouposti #TYDEN ~ 8. ledna

Čtveřice cizinců vylákala z Čechů milion korun. Proč je Substack na rozcestí. Úpadek časopisu Wired. Přejmenované Microsoft…

Historie Amigy: Zrození Commodore Amiga 1000

Vyprávěli jsme si, jak mezi firmami Commodore a Atari vzniklo velké nepřátelství. Jejich vůdci se svorně nenáviděli a chtěli…

New York Times žaluje OpenAI a Microsoft. Nejhorší technologické selhání roku 2023 #TYDEN ~ 1. ledna

Hyperloop byl vždycky podvod. Útok na iMessage bez kliknutí. Xiaomi se vrhá do aut. mujRozhlas hacknut, unikla hesla.

YouTube ani přes nahlášení nemaže podvodnou inzerci. Média mají pomáhat, ne škodit, píše David Klimeš #TYDEN 25. prosince

HP Ink od 25. ledna zdražuje. Nejhorší hry roku 2023. EasyPark unikla data zákazníků. Facebook je zahlcen kradenými obrázky…

Epic porazil Google. FTC prověřuje Adobe. Threads dorazilo do EU #TYDEN 18. prosince

Mamut se vrací, Kovář promluvil. Apple vs. Beeper Mini. RIP E3. Děravé TeamCity od JetBrains. E-knihy se rychle stávají…

Když všichni tvůrci kradou od všech: problém s opisováním

Plagiáty jsou morem současnosti. Opisují školáci, opisují youtubeři, opisují novináři, opisuje se v akademii, AI také…

Historie Amigy: …a zjevil se zlý drak Jack Tramiel

Vyprávěli jsme si o začátku historie legendární platformy Amiga. V příběhu, který trošku připomíná pohádku, jsme dospěli až…

Google představil Gemini AI, její dovednosti na videu falšoval. GTA 6 láme rekordy #TYDEN 11. prosince

Gemini AI neumí to, co Google předváděl na videu. Tesla Autopilot není bezpečný. Watzkeho Xixoio zpět na scéně. AI Alibaby…

Inzerenti na X mají dost a odcházejí, Musk je posílá do p**ele #TYDEN 4. prosince

Spotify/Apple/Youtube „wrapped“ jsou tu. Facebook a Instagram je ráj pro pedofily. Bluetooth opět děravé. AI od Amazonu…

Historie Amigy: Jak to málem skončilo dřív, než to začalo

Na předposledním Bytefestu jsem měl příležitost přednést přednášku o historii Amigy, což bylo téma pro mne velmi blízké.…

Z X odcházejí velcí inzerenti. Propagandu nelze ověřit fakty. Drama v Open AI pokračuje #TYDEN 27. listopadu

Lazarus napadl Cyberlink. „Halucinace“ slovem roku 2023. Nejpopulárnější aplikace celosvětově. Tesla věděla o závadě…